Viime viikolla tekoälymaailmaa ravisteli merkittävä julkaisu, kun kiinalainen tutkimusryhmä esitteli uuden suurten kielimallien (LLM) innovaation, DeepSeek R1:n. Tämä malli ei ainoastaan kilpaile tunnetuimpien GPT-mallien, kuten OpenAI:n GPT-4:n kanssa, vaan haastaa niitä uusilla lähestymistavoilla, jotka voivat muuttaa tekoälyn kehityksen suuntaa. Uutisissa on ihmetelty sitä, miten DeepSeek R1 on voitu kehittää selvästi pienemmillä rtesursseilla kuin amerikkalaiset tekoälymallit. Mutta miten DeepSeek R1 eroaa esimerkiksi OpenAI:n GPT-malleista?

Viime viikolla tekoälymaailmaa ravisteli merkittävä julkaisu, kun kiinalainen tutkimusryhmä esitteli uuden suurten kielimallien (LLM) innovaation, DeepSeek R1:n. Tämä malli ei ainoastaan kilpaile tunnetuimpien GPT-mallien, kuten OpenAI:n GPT-4:n kanssa, vaan haastaa niitä uusilla lähestymistavoilla, jotka voivat muuttaa tekoälyn kehityksen suuntaa. Uutisissa on ihmetelty sitä, miten DeepSeek R1 on voitu kehittää selvästi pienemmillä rtesursseilla kuin amerikkalaiset tekoälymallit. Mutta miten DeepSeek R1 eroaa esimerkiksi OpenAI:n GPT-malleista?

DeepSeek R1:n kehityksessä on otettu käyttöön puhdas vahvistusoppiminen (reinforcement learning). Toisin kuin GPT-mallit, joita koulutetaan valmiilla kysymys-vastaus-datalla ja ihmisen palautteella, DeepSeek R1 oppii itse kokeilemalla ja korjaamalla virheitään. Tätä lähestymistapaa verrataan usein lapsen oppimiseen: kuten lapsi oppii kävelemään kompastumalla, DeepSeek oppii ratkaisemaan ongelmia itsearvioinnin kautta.

DeepSeek R1 hyödyntää syvällisesti "Chain of Thought" -tekniikkaa, jossa mallia rohkaistaan selittämään ratkaisupolkunsa askel askeleelta. Tämä ei ole pelkästään käyttäjän esiin kutsuma toiminto, vaan integroitu osa DeepSeekin toimintaa. Tämä mahdollistaa mallin itsearvioinnin ja virheiden havaitsemisen reaaliajassa, mikä parantaa vastausten tarkkuutta merkittävästi.

GPT-mallit, kuten GPT-4, voivat käyttää Chain of Thought -päättelyä, mutta vain, jos käyttäjä pyytää sitä, eli tämä on kiinni prompteista. DeepSeek R1:ssä tämä on automaattinen ominaisuus, joka parantaa oppimisprosessia ja mallin kykyä sopeutua uusiin haasteisiin.

DeepSeek R1 käyttää Group Relative Policy Optimization (GRPO) -menetelmää, joka vakauttaa mallin oppimisprosessia. Tämä menetelmä minimoi yllättävät ja epävakaat muutokset mallin käyttäytymisessä, jotka ovat yleisiä perinteisissä vahvistusoppimisen malleissa. Tuloksena on tarkempi ja tasaisempi oppimiskäyrä.

GPT-mallit käyttävät Proximal Policy Optimization (PPO) -tekniikkaa, mutta GRPO on kehitetty erityisesti lisäämään oppimisen tarkkuutta ja välttämään "harharetkiä", joita voi syntyä suurten mallien koulutuksessa.

DeepSeek R1:n koko versio on valtava, sisältäen 671 miljardia parametria, minkä koulutus vaatii tuhansia GPU-prosessorita. DeepSeekin tutkijat ovat kuitenkin ottaneet käyttöön mallin distillaation. Tämä tarkoittaa, että suuri malli opettaa pienempiä malleja, kuten LLaMA 3:ta, imitoimaan sen päättelyä ja tuottamaan lähes samantasoista suorituskykyä pienemmillä resursseilla.

Tämä tekee DeepSeekistä paljon saavutettavamman kehittäjille ja tutkijoille, joilla ei ole pääsyä huipputason laitteistoon. OpenAI ei ole julkaissut vastaavia pienennettyjä versioita GPT-malleista, joten DeepSeekin lähestymistapa voi olla merkittävä askel tekoälyn demokratisoinnissa.

DeepSeek R1:n vahvuus näkyy erityisesti matemaattisessa päättelyssä, koodauksessa ja tieteellisessä ongelmanratkaisussa. Näillä alueilla se päihittää jopa GPT-4:n ja GPT-3.5:n suorituskyvyn. Tämä johtuu sen itsereflektiivisestä oppimisprosessista, joka jatkuvasti parantaa mallin vastauksia ja päättelykykyä.

DeepSeek R1 edustaa uuden sukupolven tekoälymallia, joka haastaa GPT-mallit monilla tasoilla. Sen itseohjautuva oppiminen, vahvistusoppimisen innovatiiviset tekniikat ja malli-distillaatio tekevät siitä resurssitehokkaamman ja saavutettavamman vaihtoehdon. Vaikka GPT-mallit ovat edelleen monikäyttöisempiä yleisissä sovelluksissa, DeepSeek R1 näyttää suuntaa erityisesti erikoistuneissa tehtävissä, joissa tarkkuus ja syvällinen päättely ovat avainasemassa.

Panasonic Industry on julkistanut uuden, pienen ja kustannustehokkaan PAN B511-1C -Bluetooth-moduulin, joka yhdistää erinomaisen suorituskyvyn ja suuren muistikapasiteetin erittäin alhaiseen virrankulutukseen. Moduuli perustuu Nordic nRF54L15 -piirisarjaan ja on suunniteltu erityisesti energiatehokkaita sovelluksia varten.

Panasonic Industry on julkistanut uuden, pienen ja kustannustehokkaan PAN B511-1C -Bluetooth-moduulin, joka yhdistää erinomaisen suorituskyvyn ja suuren muistikapasiteetin erittäin alhaiseen virrankulutukseen. Moduuli perustuu Nordic nRF54L15 -piirisarjaan ja on suunniteltu erityisesti energiatehokkaita sovelluksia varten.

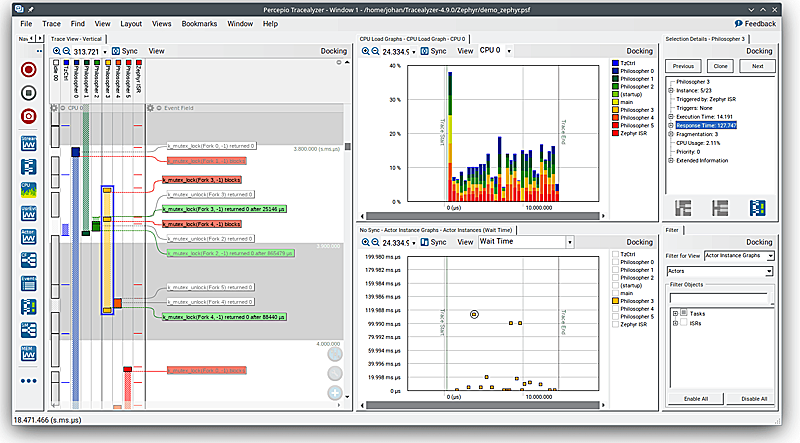

Sulautetun ohjelmistokehityksen laadunvarmistus saa uutta vahvistusta, kun Nohau Solutions ja Percepio AB ilmoittavat uudesta jakelukumppanuudesta. Yhteistyön myötä sulautetun ohjelmistokehittäjät saavat entistä paremmat työkalut koodin analysointiin, testaukseen ja diagnostiikkaan.

Sulautetun ohjelmistokehityksen laadunvarmistus saa uutta vahvistusta, kun Nohau Solutions ja Percepio AB ilmoittavat uudesta jakelukumppanuudesta. Yhteistyön myötä sulautetun ohjelmistokehittäjät saavat entistä paremmat työkalut koodin analysointiin, testaukseen ja diagnostiikkaan.

Tehokomponenttien valmistaja SemiQ on julkistanut uuden sukupolven 1200V SiC MOSFET -komponentin, joka pienentää sirukokoa samalla parantaen kytkentänopeutta ja tehokkuutta. Uusi QSiC 1200V -MOSFET on 20 % pienempi kuin edeltäjänsä, mutta tarjoaa merkittävästi parempaa suorituskykyä suurjännitesovelluksissa. Tämä kuvaa hyvin sitä nopeaa kehitystä, joka piikarbidikomponenteissa on tällä hetkellä käynnissä.

Tehokomponenttien valmistaja SemiQ on julkistanut uuden sukupolven 1200V SiC MOSFET -komponentin, joka pienentää sirukokoa samalla parantaen kytkentänopeutta ja tehokkuutta. Uusi QSiC 1200V -MOSFET on 20 % pienempi kuin edeltäjänsä, mutta tarjoaa merkittävästi parempaa suorituskykyä suurjännitesovelluksissa. Tämä kuvaa hyvin sitä nopeaa kehitystä, joka piikarbidikomponenteissa on tällä hetkellä käynnissä.

OnePlus on virallisesti ilmoittanut uusimman älykellonsa, OnePlus Watch 3:n, tulevasta julkaisusta. Uutuusmalli saapuu Euroopan ja Pohjois-Amerikan markkinoille 18. helmikuuta ja tuo mukanaan entistä paremman akunkeston ja suorituskyvyn.

OnePlus on virallisesti ilmoittanut uusimman älykellonsa, OnePlus Watch 3:n, tulevasta julkaisusta. Uutuusmalli saapuu Euroopan ja Pohjois-Amerikan markkinoille 18. helmikuuta ja tuo mukanaan entistä paremman akunkeston ja suorituskyvyn. Pekka Lundmark toimii Nokian toimitusjohtajana maaliskuun loppuun asti, jolloin vetovastuun ottaa Justin Hotard. Nokian tiedotteessakin sanotaan, että Lundmark aloitti tehtävässään hyvin vaikeaan aikaan, mutta millaisen arvosanan hän ansaitsee ajastaan toimitusjohtajana.

Pekka Lundmark toimii Nokian toimitusjohtajana maaliskuun loppuun asti, jolloin vetovastuun ottaa Justin Hotard. Nokian tiedotteessakin sanotaan, että Lundmark aloitti tehtävässään hyvin vaikeaan aikaan, mutta millaisen arvosanan hän ansaitsee ajastaan toimitusjohtajana.

Nokia on ilmoittanut tänään muutoksesta yhtiön johdossa toimitusjohtaja Pekka Lundmarkin päätettyä jättää tehtävänsä toimitusjohtajana. Nokian hallitus on nimittänyt Justin Hotardin Nokian toimitusjohtajaksi 1.4.2025 alkaen.

Nokia on ilmoittanut tänään muutoksesta yhtiön johdossa toimitusjohtaja Pekka Lundmarkin päätettyä jättää tehtävänsä toimitusjohtajana. Nokian hallitus on nimittänyt Justin Hotardin Nokian toimitusjohtajaksi 1.4.2025 alkaen.