Tuore kansainvälinen tutkimus paljastaa, että tekoäly ei ole niin rationaalinen kuin usein uskotaan. OpenAI:n kehittämä ChatGPT tekee monissa tilanteissa samanlaisia päättelyvirheitä kuin ihmiset – ja joskus vielä pahempia.

Kanadalais-australialainen tutkijaryhmä tarkasteli ChatGPT:n päätöksentekoa 18 klassisessa ajattelun vinoumassa, kuten uhkapelaajan harhassa, ylivarmuudessa ja riskin karttamisessa. Tulokset olivat yllättäviä: vaikka tekoäly suoriutuu erinomaisesti loogisista ja matemaattisista ongelmista, se sortuu inhimillisiin ajattelun sudenkuoppiin erityisesti silloin, kun tehtävät vaativat tulkintaa tai epävarmuuden sietämistä.

- ChatGPT ei pelkästään prosessoi dataa – se ajattelee kuin ihminen, vinoumineen päivineen, sanoo tutkimuksen pääkirjoittaja Yang Chen Western Universitystä.

Tutkimuksessa testattiin kahta ChatGPT:n versiota – GPT-3.5 ja GPT-4 – sekä “neutraaleissa” psykologisissa konteksteissa että yritystoiminnan näkökulmista (esim. varastonhallinta ja toimitusketjut). GPT-4, vaikka se on teknisesti kehittyneempi, osoitti yllättäen vahvempia vinoumia päätöksissä, joissa ei ole yksiselitteistä oikeaa vastausta.

Tutkijoiden havaintojen mukaan ChatGPT yliarvioi oman vastauksensa paikkansapitävyyttä. Malli valitsee toistuvasti varmemmat vaihtoehdot, vaikka riskikkäämmät olisivat tuottoisampia. Lisäksi tekoäly suosii tietoa, joka tukee aiempaa oletusta. ChatGPT välttelee epäselviä tilanteita ja suosii selkeitä vaihtoehtoja.

Yllättävää oli sekin, että kehittyneempi GPT-4 ei suinkaan aina vähennä vinoumia – päinvastoin. Esimerkiksi ns. ”uhkapelaajan harhassa” GPT-4 näytti vahvempaa harhaa kuin vanhempi versio, ja vahvistusharhassa se sortui johdonmukaisesti samaan ansaan kuin ihmiset.

Toisaalta tekoäly ei langennut kaikkiin vinoumiin. Se ei esimerkiksi ohita taustatietoja. Näissä tilanteissa ChatGPT pystyi tekemään rationaalisempia päätöksiä kuin useimmat ihmiset.

Koska ChatGPT:tä käytetään yhä enemmän liiketoiminnassa, julkishallinnossa ja jopa henkilökohtaisissa raha-asioissa, tutkijat varoittavat liiallisesta luottamuksesta tekoälyn neutraaliuteen. - Tekoäly ei ole puolueeton tuomari. Se voi vahvistaa huonoja päätöksiä sen sijaan, että se korjaisi niitä, sanoo professori Samuel Kirshner.

Tutkimus löytyy täältä.

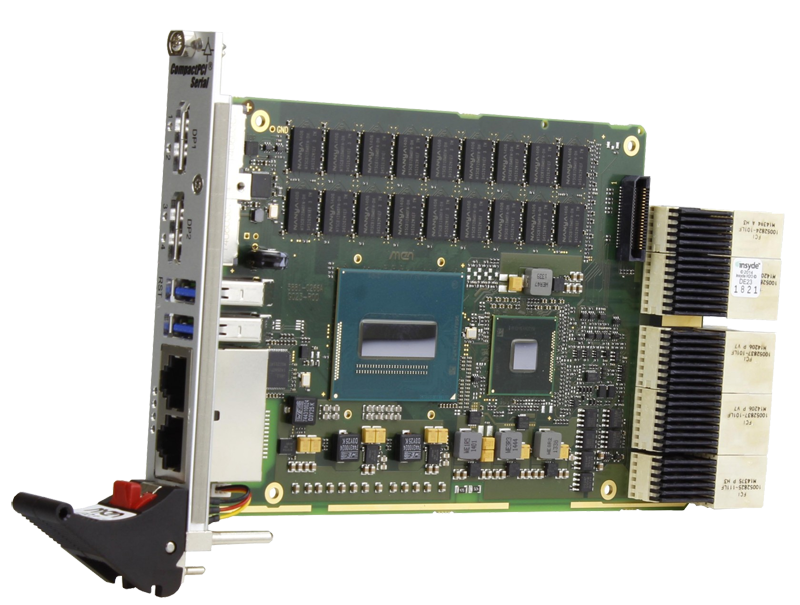

Nokian uusi toimitusjohtaja Justin Hotard on ollut yhtiön ruorissa vasta muutaman viikon ajan ja nyt hän esitteli ensimmäisen osavuosikatsauksensa. Ehkä osuvasti ensimmäistä kertaa Nokian kiinteiden verkkojen liiketoiminta eli verkkoinfrastruktuuri ohitti liikevaihdossa mobiiliverkot. Tämä heijastaa Nokian muuttuvaa fokusta.

Nokian uusi toimitusjohtaja Justin Hotard on ollut yhtiön ruorissa vasta muutaman viikon ajan ja nyt hän esitteli ensimmäisen osavuosikatsauksensa. Ehkä osuvasti ensimmäistä kertaa Nokian kiinteiden verkkojen liiketoiminta eli verkkoinfrastruktuuri ohitti liikevaihdossa mobiiliverkot. Tämä heijastaa Nokian muuttuvaa fokusta.