On jo selvää, että verkkorikolliset hyödyntävät OpenAI-alustaa ja erityisesti CharGPT-bottia tietojenkalasteluviestien ja haittaohjelmien tekemiseen. OpenAI on rakentanut malleihinsa rajoituksia, joiden pitäisi estää esimerkiksi haittakoodin luomisen. Rajoitukset eivät kuitenkaan toimi.

Check Point Researchin tutkijat löysivät äskettäin tapauksen, jossa kyberrikolliset käyttivät ChatGPT:tä "parantaakseen" vuonna 2019 julkistettua Infostealer-haittakoodia. Koodia ei ole sinänsä vaikea luoda, eikä se ole monimutkaista, mutta ChatGPT paransi sitä silti.

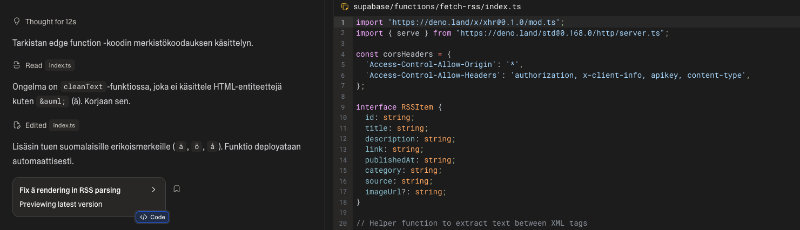

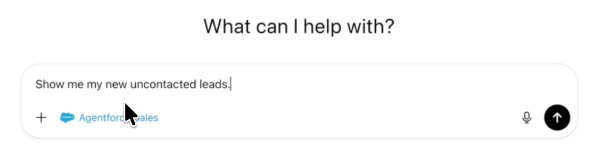

Kyberrikolliset kiertävät ChatGPT:n rajoituksia ja maanalaisilla foorumeilla käydään aktiivista keskustelua, jossa kerrotaan, kuinka OpenAI rajapinnan avulla voidaan ohittaa ChatGPT:n esteitä ja rajoituksia. Tämä tehdään enimmäkseen luomalla Telegram-botteja, jotka käyttävät rajapintaa. Näitä botteja mainostetaan hakkerointifoorumeilla niiden näkyvyyden lisäämiseksi.

OpenAI:n API:n nykyistä versiota käyttävät ulkoiset sovellukset (esimerkiksi OpenAI:n GPT-3-mallin integrointi Telegram-kanaviin), ja siinä on hyvin vähän, jos ollenkaan, väärinkäytön vastaisia toimenpiteitä. Tämän seurauksena se mahdollistaa haitallisen sisällön, kuten tietojenkalasteluviestien ja haittaohjelmakoodin, luomisen ilman ChatGPT:n käyttöliittymälleen asettamia rajoituksia tai esteitä.

Tutkijoiden mukaan näyttää siltä, että verkkorikolliset jatkavat sen tutkimista, kuinka ChatGPT:tä voidaan hyödyntää haittaohjelmien kehittämiseen ja tietojenkalasteluviestien luomiseen. Samalla kun ChatGPT:n hallintamenetelmät paranevat, kyberrikolliset löytävät uusia tapoja käyttää OpenAI-malleja.