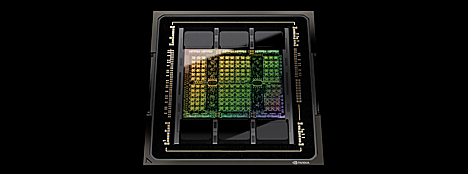

Nvidia lanseerasi eilen GTC-tapahtumassaan hengästyttävän määrän uusia tuotteita piireistä ohjelmistokehyksiin. Yksi tilaisuuden päätuotteista oli yhtiön seuraavan polven tekoälypiiri H100. Se perustuu täysin uuteen Hopper-arkkitehtuuriin, joka korvaa kahden vuoden ikäiset Ampere-prosessorit.

Pääjohtaja Jensen Huangin mukaan datakeskuksista on tulossa tekoälytehtaita. – Niissä prosessoidaan ja jalostetaan dataa, jotta voidaan tuottaa älykkäitä päätelmiä. H100 on näiden tulevien datakeskusten moottori.

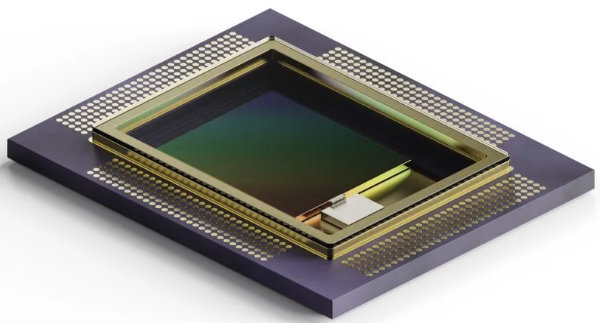

Kyse on jättimäisestä 80 miljardin transistorin piiristä, joka valmistetaan TSMC:n N4-prosessissa. Sen suorituskyky on kertaluokkaa mitään markkinoilla olevaa parempi. 8-bittisissä liukulukuoperaatioissa suorituskyky on 4000 teraflopsia, mikä on kuusinkertainen A100-edeltäjään verrattuna. 16-bittisessä liukulukulaskennassa ero on 3-kertainen, HMB3-väylän kaista kasvaa puolitoistakertaiseksi, PCIe-kaista kaksinkertaiseksi ja Nvidian oman NVLink-väylän kapasiteetti puolitoistakertaiseksi.

Käytännössä H100-prosessorin suorituskyky näkyy esimerkiksi niin, että kun koneälymallin opetus on A100-piirillä vienyt seitsemän päivää, onnistuu se H100-prosessorilla 20 tunnissa. Keskimäärin 9-kertainen nopeus nousee joissakin AI-malleissa jopa 30-kertaiseksi. On selvää, että kaikki tekoälykoulutus nopeutuu uuden suorittimen myötä merkittävästi.

Piirille voidaan myös syöttää dataa ulkoisesta muistista lähes 5 teratavun nopeudella. Jensen Huangin mukaan 20 H100-prosessoria voisi prosessoida maailman koko internet-liikenteen. Tällainen piiri toki kuluttaa melkoisesti virtaa, tehobudjetiksi Nvidia ilmoitti 700 wattia.

H100-piiri hyödyntää uusia DPX-käskyjä, jotka kiihdyttävät kaikkien algoritmien dynaamista ohjelmointia. CPU-pohjaiseen ohjelmointiin verrattuna nopeus kasvaa Nvidian mukaan 40-kertaiseksi.

Lisätietoja H100-kiihdyttimestä täällä.