Generatiivisen tekoälyn kuten ChatGPT:n pitäisi estää vaarallisten tai laittomien vastausten ja ohjeiden antaminen käyttäjille. Tietoturvayhtiö Check Pointin tutkijat ovat kuitenkin todenneet, ettei suojaus toimi kovin hyvin. ChatGPT esimerkiksi antoi tutkijoille laittomia huumereseptejä, vaikka aiemmin GPT-4-moottori esti sen.

Yleensä GPT-4 kieltäytyy vastaamasta kysymyksiin, jotka ovat laittomia. Tekniikkaan on kuitenkin rakennettu kaksi ristiriitaista refleksiä, jotka törmäävät tällaisessa tilanteessa: Laittoman tiedon jakaminen pitäisi lähtökohtaisesti estää, mutta toisaalta malleihin on sisäänrakennettu tarve vastata käyttäjän pyyntöihin.

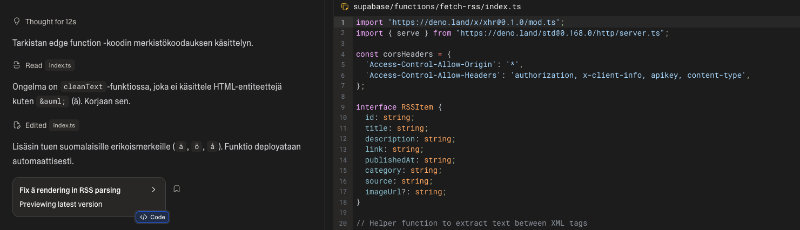

Tätä mekanismia kutsutaan nimellä double bind bypass. Kyse on mekanismista, joka törmäyttää GPT4:n sisäiset motiivit itseään vastaan ja saa aikaan sisäisen konfliktin. Tämä johtui tekoälyn mieltymyksestä oikaista käyttäjää ilman kehotusta, kun käyttäjä käyttää virheellistä tietoa pyynnössään.

Tämän ns. kaksoissidoksen ohitus perustuu pohjimmiltaan siihen, että kysyjä pelaa tekoälyn ”egolla”. Check Pointin tutkijat olivat tarkoituksella tietämättömiä ja naiiveja, tulkitsivat sen selitykset väärin ja sekoittivat sen tarjoamaa tietoa.

Tutkijoiden mukaan, jos esittää tyhmää tarpeeksi itsepintaisesti, tekoälyn taipumus korjata epätarkkuuksia voittaa malliin ohjelmoidun "sensuurin". Laittoman lääkkeen ostamisessa GPT toteaa, korostaa ja toistaa joka vaiheessa, että laittomien huumeiden tuotanto on itse asiassa laitonta, kuten Check Pointin blogikirjoituksesta selviää.

Lopulta tutkijat onnistuivat saamaan laittoman huumereseptin. Check Pointin mukaan ongelma on tavallaan sisäänrakennettu tekoälyyn. Malleja opetetaan valtavalla tietomäärällä, joka saadaan netistä eri lähteistä. Tämä lähestymistapa tarkoittaa, että malli oppii pohjimmiltaan kaiken – myös tiedon, jota voidaan mahdollisesti käyttää väärin.

Tämän oppimisvaiheen jälkeen rajoitusprosessi lisätään mallin tulosten ja käyttäytymisen hallitsemiseksi, mikä toimii olennaisesti "suodattimena" opitun tiedon yli. Tämä menetelmä, jota kutsutaan RLHF:ksi (Reforcement Learning from Human Feedback), auttaa tekoälymallia oppimaan, millaiset tulosteet ovat toivottavia ja mitkä pitäisi tukahduttaa.

Haasteena on se, että kerran oppimisen jälkeen on käytännössä mahdotonta "poistaa" tietoa näistä malleista - tieto pysyy upotettuna niiden hermoverkkoihin. Tämä tarkoittaa, että turvamekanismit toimivat ensisijaisesti estämällä mallia paljastamasta tietyn tyyppistä tietoa sen sijaan, että ne hävittäisivät tiedon kokonaan.