Suuria kielimalleja (LLM) kohtaan on ollut paljon kiinnostusta ChatGPT:n nopeasti kasvaneen suosion ansiosta. Näiden mallien kouluttaminen vaatii valtavan määrän laskentatehoa. Turun yliopiston tutkijat kääntyivät Kajaanissa sijaitsevan LUMI-superkoneen puoleen, kun haluttiin laajentaa tekoälymallien käyttöä tutkimussovelluksissa.

Yliopiston tutkija Sampo Pyysalo tarvitsi paljon suorituskykyä mallien kouluttamiseksi lyhyessä ajassa. Apuun tuli LUMI-supertietokone, joka perustuu HPE Cray EX -supertietokonearkkitehtuuriin ja joka toimii AMD:n EPYC-suorittimilla ja Instinct-grafiikkasuorittimilla.

Pyysalon tavoitteena oli kumppaneiden Risto Luukkosen ja Ville Komulaisen kanssa TurkuNLP:ssä tuoda suuret suuret kielimallit akateemiseen käyttöön. - Suuret toimijat ovat suuria monikansallisia yrityksiä, jotka pitävät mallinsa suljettuina. Akateemisessa maailmassa haluamme käytännön pääsyn tällaisiin malleihin, joten olemme luoneet niitä itse ja tämä vaatii supertietokoneresursseja, Pyysalo perustelee.

Kielimallien rakentaminen perustuu kehittyneisiin tekoälyn (AI) ja koneoppimisen (ML) työkaluihin. Pyysalo on työskennellyt tätä varten Hugging Facen kanssa. - Olemme tehneet yhteistyötä Hugging Facen kanssa useissa projekteissa. Olimme osa BigScience-hankkeita, jotka loivat BLOOMin, suurimman avoimen kielimallin. Työmme LUMI-pilotin aikana oli opettaa BLOOMille suomea. Otimme Hugging Facen luoman 176 miljardin parametrin mallin ja yhdistimme sen suomeen käyttämällä 40 miljardia sanaa lisää.

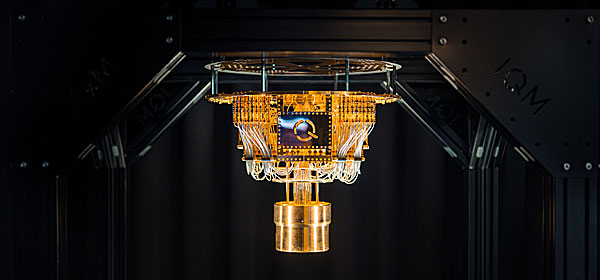

Tämän kokoiset mallit vaativat valtavan laskentakapasiteetin ja siinä LUMI osoittautui välttämättömäksi. EuroHPC-yhteisyrityksen omistaman LUMIn rahoittivat puoliksi EuroHPC JU ja kymmenestä Euroopan maasta koostuva LUMI-konsortio. Sen kotipaikka on Suomen Kajaanissa CSC:n eli Tieteen tietotekniikan keskuksen palvelinkeskuksessa.

LUMI-G-grafiikkasuoritinosio on merkittävästi tehokkaampi kuin CSC:n laitteiden aiemmat GPU-osiot. LUMI:ssa on 2 560 solmua, joissa on AMD EPYC -prosessorit, joista jokaisessa on neljä AMD Instinct MI250x -kiihdytintä. Kaikkiaan GPU-prosessoreista on 10 240 kappaletta. Yksittäisiä grafiikkaprosessorisiruja on kaksinkertainen määrä eli 20 480 kappaletta.

- Tarvitaan paljon laskentatehoa mallin luomiseksi kohtuullisessa ajassa. Tässä mittakaavassa iso haaste oli saada järjestelmä ylipäätään toimimaan. Sen lisäksi on kyettävä nostamaan tietoja tehokkaasti tallennustilasta, ajamaan tehokkaita ytimiä ja siirtämään dataa edestakaisin GPU:n ja päämuistin välillä. Toinen suuri skaalaushaaste on viestintä. Kun jokainen GPU on laskenut osansa mallista, kaikki on yhdistettävä. Laskenta pitää kuitenkin jakaa sadoille tai jopa tuhansille laitteille, Pyysalo kuvaa haasteita.