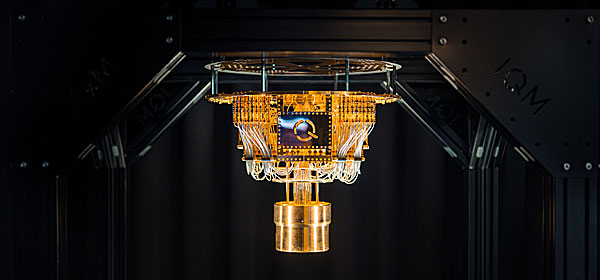

Tekoälyä käytetään yhä laajemmin apuna, kun erilaisiin järjestelmiin murtaudutaan. Ruotsin puolustusministeriön alainen tutkimusinstituutti FOI on laatinut raportin, jonka mukaan verkkorikollisten on mahdollista murtautua myös tekoälyä hyödyntäviin sotilassovelluksiin.

Ruotsi on yhä kiinnostuneempi tekoälyn käytöstä sotilaallisissa yhteyksissä. Tämän vuoksi on mielenkiintoista tutkia niiden haavoittuvuuksia, jotka ovat täysin uudenlaisia. Seitsemän FOI:n kyberpuolustus- ja hallintateknologiaosaston tutkijaa on tutkinut lähemmin kolmea menetelmää koneoppimis- eli ML-järjestelmien sabotoimiseksi.

Raportissa tarkastellaan erityisesti vihamieliseen koneoppimiseen perustuvia hyökkäyksiä. Ensin tutkijat tarkastelivat kuvanluokittelun manipulointia, jota kutsutaan myös termillä myrkytys (poisoning). Siinä manipuloidaan dataa, jolla järjestelmää koulutetaan tunnistamaan ja luokittelemaan esimerkiksi tankkeja.

Tutkijat totesivat, että myrkytys todella toimi, koska sabotoija tietää suunnilleen, millainen koneoppimisjärjestelmä on kyseessä. Internetissä on suuria kokoelmia kuvia ja muuta dataa koneoppimisjärjestelmien koulutusta varten, joita kuka tahansa voi ladata. - Testasimme myrkytyskoulutuskuvia niin, että jotkut tankit luokiteltiin väärin autoiksi, kertoo yksi raportin tekijöistä Björn Pelzer.

Toisessa tapauksessa tutkijat testasivat, oliko mahdollista poimia salaisia tietoja suurista generatiivisista kielimalleista, kuten ChatGPT.

Tällä hetkellä on vain vähän merkkejä siitä, että tutkijoiden tutkimia hyökkäyksiä hyödynnettäisiin käytännössä. Mutta he pelkäävät, että siitä tulee ongelma tulevaisuudessa, kun yhä enemmän käytetään tekoälyjärjestelmiä.

Raporttiin voi tutustua täällä.