Tekoälyllä voidaan jo tuottaa haittakoodia, mutta turvallisuus on paremmassa jamassa kuin koskaan aikaisemmin. - Ei tosin ole mitään syytä olettaa, että tekoälyn kehitys pysähtyisi ihmisen älyn tasolle, sanoi WithSecuren tutkimusjohtaja Mikko Hyppönen eilen yhtiönsä SPHERE24-tapahtumassa.

Olemme pian kahden vuoden ajan eläneet ChatGPT-aikaa. Hyppösen mukaan kyse on uudesta teknologisesta vallankumouksesta, joita meidän aikanamme on jo nähty muutama. Älypuhelin oli sellainen ja verkkoyhteys kaikkialla - joskus sitä kutsutaan konnektiviteetiksi - toinen. Kuten aina, myös GenAI tuo teknologisena mullistuksena sekä etuja että hyötyjä. - Emme voi valita vain hyötyjä, Hyppönen muistutti.

Vallankumouksen tullessa meillä on taipumus yliarvioida nopeutta ja aliarvioida sen laajuutta. Hyppösen mukaan näin tapahtuu myös AI:n kanssa. - Eivät internetvallankumoukset lupaukset täyttyneet heti, mutta nyt ne ovat täyttä totta. Se vain vei 20 vuotta aikaa.

Mitä tekoälyllä voi sitten rakentaa? Mitä tahansa, Hyppönen sanoo. Esineitä, palveluita, emme vielä tiedä mitä kaikkea. Tekoäly on erittäin hyvä tunnistamaan anomalioita, minkä takia se on erinomainen apuri esimerkiksi kyberturvayritykselle.

- Tekoäly voi huomata, että kaksi palvelinta keskustelevat keskenään vaikka niiden ei pitäisi. Miksi tämä läppäri heräsi toimintaan klo 4 aamulla? Nämä mekamismit voivat varoittaa organisaatiota siitä, että kyberhyökkäys on tapahtunut ennen kuin mitään katastrofaalista tapahtuu.

Elon Musk kirjoitti viime vuonna kirjeen, jossa vaadittiin taukoa GenAI-kehitykselle. Kyyninen voisi sanoa, että Musk halusi aikaa omalle xAI-projektilleen. Mikko Hyppönen ei tätä kirjettä allekirjoittanut, vaikka moni muu niin tekikin. Tekoälyn kehityksen rajoittamiseen hän ei usko. Itse asiassa hän uskoo, ettei ihmisen älykkyys ole mikään raja tekoälyn kehitykselle.

- Generatiiviselle tekoälylle voi antaa sen antaa sen oman lähdekoodin ja pyytää sitä parantamaan itseään. Sen jälkeen GenAI voi kääntää koodin, julkaista sen ja kertoa, miten olet parantunut itseäsi. Lopulta päädymme johonkin, mitä emme enää ymmärrä, ja jolla ei ole ihmisen ymmärryksen rajoituksia.

Missä vaiheessa sitten olemme nyt? Tekoälyn tuottamia hyökkäyksiä ei vielä tapahdu, ei ainakaan laajassa mittakaavassa. Uutisten mukaan yrityksiin on jo hyökätty väärennetyillä Teams-puheluilla, mutta tätäkään ei vielä ole tapahtunut laajassa mittakaavassa. Hyppönen tietää itse kahdesta deepfake-tekniikalla tehdystä Teams-huijauksesta, mutta nekin on tehty etukäteen, ei reaaliajassa.

Yksi mahdollinen ratkaisu olisi ollut tietynlaisten promptien kieltäminen, mutta sen suhteen OpenAI toimi liian hitaasti. Moni yritys kehitti jo virtuaalisia tyttöystäviä, mikä avasi samalla oven ns. Deepscams-huijauksille. Tällä oli kuitenkin iso merkitys OpenAI:n strategian kannalta. Yhtiö hylkäsi avoimen lähdekoodin ja siitä tuli suljettu. Pelkkä palvelu, jota ei voi ladata.

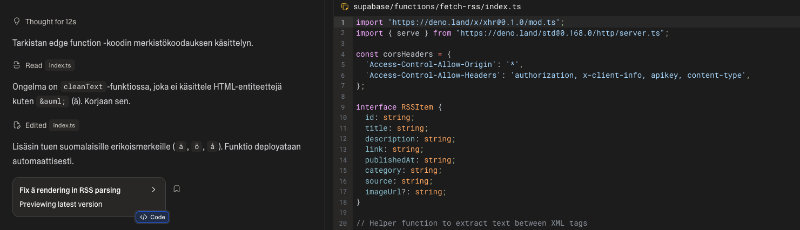

Seuraavana tulossa on kuitenkin suureen kielimalliin perustuva haittaohjelma. Siis Large Language Malware. - Ennusten, että aika pian näemme ensimmäisen haittaohjelman, joka kantaa LLM-mallia mukanaan eli ei tarvitse nettiyhteyttä. Tähän menee ehkä muutama vuosi.

- Haittaohjelmakampanjoiden automatisoinnin piti tapahtua jo, mutta sitä ei ole tapahtunut. Kun WithSecure blokkaa IP-osoitteen, hyökkääjillä kestää aikaa huomata tämä. Uuden domainin rekisteröinti bottiverkolle vie tunteja tai päiviä, kun me reagoimme minuuteissa. Tässä tietoturvayritykset ovat parempia.

Tämä ei auta ikuisesti. Tekoäly voi parantaa mitä tahansa koodia, myös haittakoodia. - Seuraavassa vaiheessa ei anneta tekoälylle lähdekoodia vaan binäärikoodi. Etsi siitä bugit, valitse ne jotka on helpointa hyödyntää ja tee näitä aukkoja hyödyntävä koodi. Tämä on hienoa, jos yrität parantaa omaa koodiasi, mutta jos joku muu yrittää löytää koodistasi aukkoja, se on huonompi juttu, Hyppönen päätti.