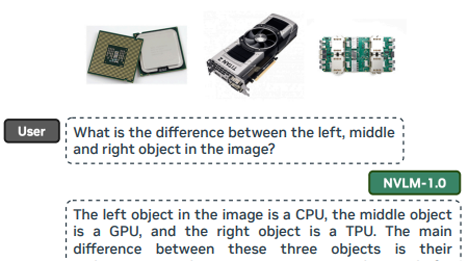

NVIDIA on julkaissut uuden avoimen LLM-mallin. NVLM 1.0 kilpailee johtavien multimodaalisten kielimallien, kuten OpenAI:n GPT-4:n kanssa. Se näyttää testien perusteella suoriutuvan erityisen hyvin visuaalis-kielellisistä tehtävistä eli malli osaa selittää kuvia ja eri kuvien eroja.

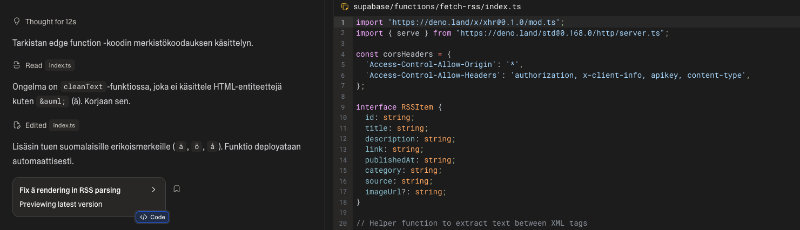

Toisin kuin GPT-4, jonka malliarkkitehtuurit ja datat ovat suurelta osin suljettuja, NVLM 1.0 julkaisee malliensa painot ja avaa koodinsa tutkimusyhteisön käyttöön. Tämä tarjoaa merkittävän edun tutkimuksen ja kehityksen kannalta.

NVLM 1.0:ssa on kolme arkkitehtuurivaihtoehtoa: decoder-only (NVLM-D), cross-attention (NVLM-X) ja hybridi-arkkitehtuuri (NVLM-H). Tämä eroaa GPT-4:n yhden neuroverkon mallista, joka käsittelee teksti- ja kuvasyötteitä ilman erillisiä moduuleja. NVLM tarjoaa erillisiä arkkitehtuurivaihtoehtoja, joista jokaisella on vahvuutensa erilaisissa laskentatehtävissä.

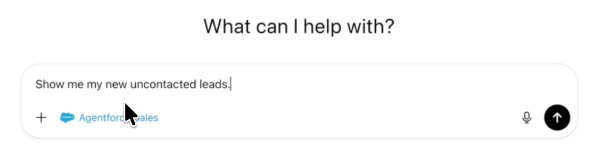

NVLM 1.0 on suunniteltu erityisesti kuvien tunnistukseen ja muihin visuaalis-kielellisiin haasteisiin. Se käyttää dynaamisia korkearesoluutioisia kuvia, mikä parantaa suorituskykyä tehtävissä, kuten tekstintunnistuksessa ja matemaattisessa päättelyssä. GPT-4 on erittäin monipuolinen, mutta se ei ole yhtä optimoitu skannattuihin tai korkearesoluutioisiin kuviin liittyvissä tehtävissä.

GPT-4 on tunnettu kyvystään toimia hyvin sekä teksti- että multimodaalisissa tehtävissä ilman suorituskyvyn heikkenemistä. NVLM 1.0, erityisesti NVLM-D-versio, parantaa multimodaalikoulutuksen aikana jopa mallin tekstipohjaista suorituskykyä matemaattisissa ja koodauksen prosessoinnissa.

GPT-4:n vahvuus on sen kyky yhdistää teksti- ja kuvadatan käsittely sujuvasti. Vaikka NVLM tarjoaa myös kattavan multimodaalikäsittelyn, se eriyttää kuvat ja tekstin eri moduuleilla, mikä voi tarjota enemmän joustavuutta, mutta saattaa olla vähemmän sujuva käytössä kuin GPT-4:n yhtenäinen malliarkkitehtuuri.