![]() Kun suurteholaskennan (HPC) työkuormat monimutkaistuvat, generatiivinen tekoäly sulautuu yhä tiiviimmin moderneihin järjestelmiin ja lisää kehittyneiden muistiratkaisujen tarvetta. Vastatakseen näihin muuttuviin vaatimuksiin ala kehittää uuden sukupolven muistiarkkitehtuureja, jotka maksimoivat kaistanleveyden, minimoivat latenssin ja parantavat energiatehokkuutta.

Kun suurteholaskennan (HPC) työkuormat monimutkaistuvat, generatiivinen tekoäly sulautuu yhä tiiviimmin moderneihin järjestelmiin ja lisää kehittyneiden muistiratkaisujen tarvetta. Vastatakseen näihin muuttuviin vaatimuksiin ala kehittää uuden sukupolven muistiarkkitehtuureja, jotka maksimoivat kaistanleveyden, minimoivat latenssin ja parantavat energiatehokkuutta.

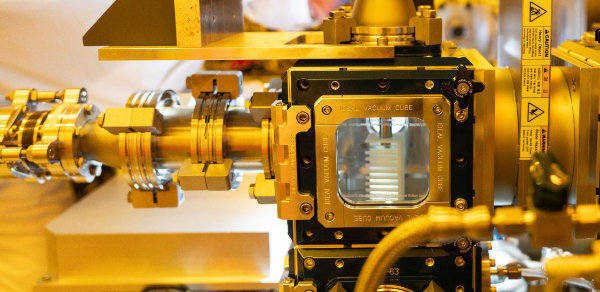

DRAM:n, LPDDR:n ja erikoismuistien edistysaskeleet määrittelevät tietojenkäsittelyn suorituskykyä uudelleen. Tekoälylle optimoitu muistiteknologia on keskiössä, kun tavoitellaan tehokkuutta ja skaalautuvuutta. Winbondin CUBE-muisti on tästä hyvä esimerkki: se tarjoaa suurikaistaisen ja vähävirtaisen ratkaisun tekoälyn ohjaamille työkuormille. Tässä artikkelissa tarkastellaan muistiteknologian viimeisimpiä läpimurtoja, tekoälysovellusten kasvavaa vaikutusta ja Winbondin strategisia toimia markkinoiden muuttuviin tarpeisiin vastaamiseksi.

Kehittyneet muistiarkkitehtuurit ja suorituskyvyn skaalautuminen

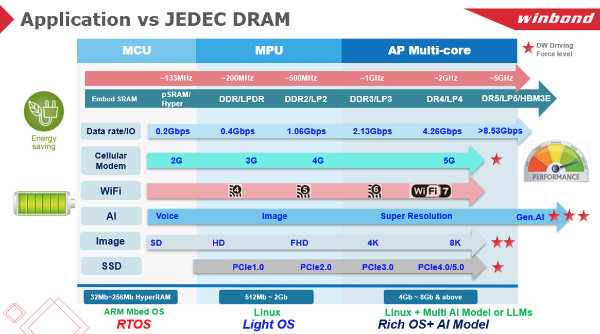

Muistiteknologia kehittyy vastaamaan tekoälyn, AIoT:n ja 5G-järjestelmien tiukkoja suorituskykyvaatimuksia. Ala näkee paradigman muutoksen DDR5:n ja HBM3E:n laajassa käyttöönotossa, sillä ne tarjoavat suurempaa kaistanleveyttä ja parempaa energiatehokkuutta. DDR5 yltää jopa 6,4 Gbps:n pinnakohtaiseen datanopeuteen ja 51,2 GB/s moduulikohtaiseen siirtonopeuteen—lähes kaksinkertaiseen DDR4:ään verrattuna—ja samalla se pienentää käyttöjännitteen 1,2 voltista 1,1 volttiin energiatehokkuuden parantamiseksi. HBM3E kasvattaa kaistanleveyttä yli 1,2 teratavuun pinoa kohti, mikä tekee siitä houkuttelevan ratkaisun dataraskaisiin tekoälyn harjoitusmalleihin. Se ei kuitenkaan sovellu mobiili- ja edge-laitteisiin suuren tehonkulutuksen vuoksi.

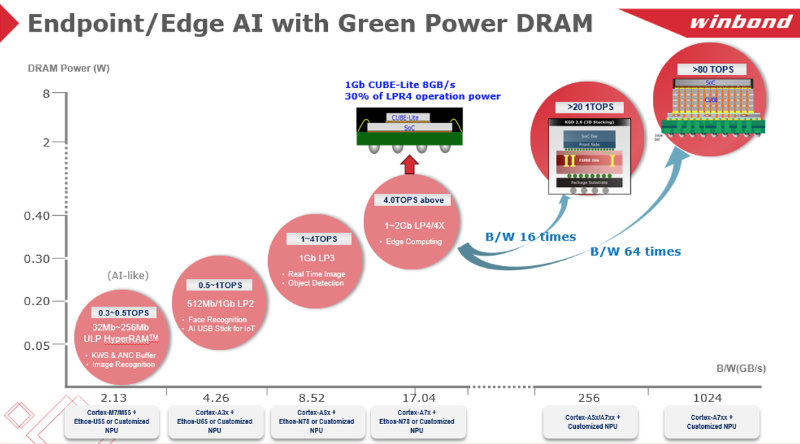

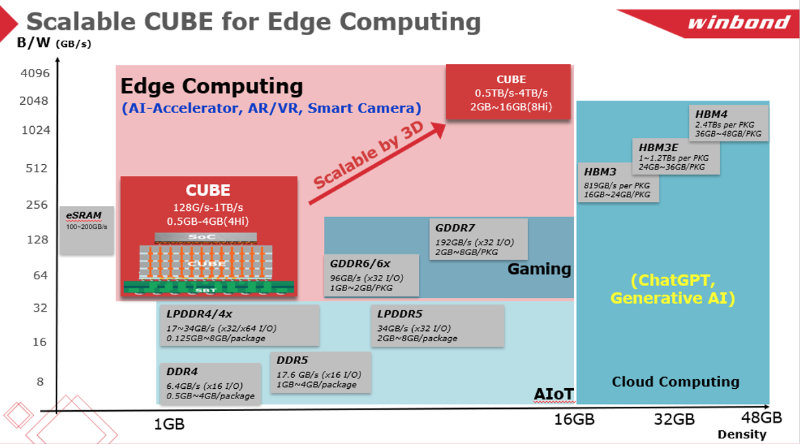

Kun LPDDR6:n ennakoidaan ylittävän 150 GB/s vuonna 2026, vähävirtaiset DRAM-tekniikat kehittyvät kohti suurempaa kaistanleveyttä ja energiatehokkuutta, erityisesti tekoälypuhelinten ja sulautettujen AI-kiihdyttimien tarpeisiin. Winbond kehittää aktiivisesti pienikapasiteettisia DDR5- ja LPDDR4-ratkaisuja virtapiheihin sovelluksiin ja on samalla edelläkävijä CUBE-muistissa, joka saavuttaa yli 1 TB/s kaistanleveyden selvästi pienemmällä lämmöntuotolla. Kapasiteetin ennakoidaan skaalautuvan 8 gigatavuun tai jopa korkeammalle—kuten 4Hi WoW -ratkaisussa, joka saavuttaa yli 40 gigatavun tiheyden ja yli 40 TB/s kaistanleveyden. CUBE asemoituu ylivoimaiseksi vaihtoehdoksi perinteisille DRAM-ratkaisuille tekoälypohjaisessa edge-laskennassa.

CUBE-teknologiasta on olemassa myös CUBE-Lite-versio, joka tarjoaa 8 GB/s kaistanleveyden (vastaa LPDDR4x x16 -kaistaa) ja kuluttaa vain 30 % LPDDR4x:n tehosta. Lisäksi SoC voidaan toteuttaa ilman LPDDR4 PHY:tä käyttäen vain CUBE-light-ohjainta, mikä pienentää sirun pinta-alaa ja parantaa tehonkulutusta. Arkkitehtuuri sopii AI-SoC-ratkaisuihin (MCU:t + MPU:t + NPU:t), ja erityisesti akkuvirtaa hyödyntäviin TinyML-laitteisiin. Käyttöjärjestelmänä toimii Micro Linux ja AI-malli AI-SoC:lle. Loppusovelluksia ovat AI-ISP IP-kameroissa, älylaseissa ja puettavissa laitteissa.

GenAI:n muistin pullonkaulat

Generatiivisten AI-mallien eksponentiaalinen kasvu aiheuttaa ennennäkemättömiä muistikaistan ja latenssin rajoitteita. Tekoälytyökuormat, erityisesti transformer-arkkitehtuureihin perustuvat, vaativat huomattavaa laskentatehoa ja suurinopeuksista datan hakua.

Esimerkiksi LLamA2 7B:n käyttö INT8-tilassa vaatii vähintään 7 Gt DRAM-muistia tai 3,5 Gt INT4-tilassa, mikä korostaa perinteisten mobiilimuistien kapasiteettirajoja. Nykyiset tekoälypuhelimet, jotka hyödyntävät LPDDR5-muistia (68 GB/s), kärsivät merkittävistä pullonkauloista ja vaativat siirtymistä LPDDR6:een. Tarvitaan kuitenkin väliaikaisia ratkaisuja, kunnes LPDDR6 yleistyy.

Järjestelmätasolla tekoälyn edge-sovellukset robotiikassa, autonomisissa ajoneuvoissa ja älysensoreissa asettavat lisävaatimuksia energiatehokkuudelle ja lämmönhallinnalle. Vaikka JEDEC-standardit kehittyvät kohti DDR6:ta ja HBM4:ää kaistanleveyden parantamiseksi, räätälöidyt muistiratkaisut, kuten Winbondin CUBE, tarjoavat skaalautuvia ja suorituskykyisiä vaihtoehtoja AI-SoC-suunnitteluun. CUBE yhdistää HBM-tasoisen kaistanleveyden alle 10 watin tehonkulutukseen, mikä tekee siitä varteenotettavan ratkaisun inferenssiin verkon reunalla.

Lämmönhallinnan ja energiatehokkuuden rajoitteet

Suurten AI-mallien käyttö päätelaitteissa tuo merkittäviä haasteita lämmönhallintaan ja energiankäyttöön. Tekoälypohjaiset työkuormat kuluttavat luonnostaan paljon tehoa ja tuottavat lämpöä, joka voi heikentää järjestelmän vakautta ja suorituskykyä.

- Laitteen sisäisen muistin kasvattaminen: Mobiililaitteisiin on integroitava suurempikapasiteettisia muistiratkaisuja, jotta ne voivat vähentää pilvipalveluiden käyttöä ja latenssia. Perinteisen DRAM:n skaalautuminen lähestyy fyysisiä rajojaan, joten tarvitaan hybridimuistiarkkitehtuureja, jotka yhdistävät suuren kaistanleveyden ja pienen tehonkulutuksen.

- HBM3E vs. CUBE AI-SoC:eissa: HBM3E saavuttaa suuren läpimenon, mutta sen yli 30 watin tehonkulutus per pino tekee siitä sopimattoman mobiili- ja edge-käyttöön. Winbondin CUBE voi toimia LLC-muistina (Last Level Cache), mikä vähentää sirun sisäisen SRAM-muistin tarvetta ja tarjoaa silti suurinopeuksisen datayhteyden. Kun logiikkaprosessit siirtyvät alle 7 nm kokoluokkaan, SRAM:n skaalausrajoitukset korostuvat ja uuden sukupolven välimuistit ovat välttämättömiä.

- Lämmön optimointi: Tekoälylaskenta voi tuottaa yli 15 watin lämpökuormia per siru, joten tehon jakelu ja lämmönpoisto ovat kriittisiä. Mukautetut DRAM-ratkaisut, jotka optimoivat virkistyssyklit ja hyödyntävät TSV-pohjaisia kotelointitekniikoita, kuten CUBE, parantavat energiatehokkuutta kompakteissa laitteissa.

DDR5 ja DDR6 vauhdittajina

DDR5:n ja DDR6:n kehitys on merkittävä taitekohta tekoälyjärjestelmien arkkitehtuurissa. Ne tarjoavat aiempaa suurempaa kaistanleveyttä, pienempää latenssia ja parempaa skaalautuvuutta.

DDR5:n 8-bank group -arkkitehtuuri ja on-die ECC parantavat tietojen eheyttä ja tehokkuutta, mikä tekee siitä sopivan tekoälyllä tehostettuihin PC:ihin ja tehokkaisiin kannettaviin. 51,2 GB/s huippunopeus per moduuli mahdollistaa reaaliaikaisen tekoälyinferencesin, nopean moniajon ja datankäsittelyn. Kehitteillä oleva DDR6 on tuomassa yli 200 GB/s moduulikohtaista kaistanleveyttä, 20 % pienemmän tehonkulutuksen ja optimoidun tuen AI-kiihdyttimille.

Winbond tekoälymuistin kehittäjänä

Winbondin markkinastrategia edistää räätälöityjen DRAM-arkkitehtuurien kehitystä tekoälykeskeisiin työkuormiin ja sulautettuihin sovelluksiin.

- CUBE tekoälylle optimoituna muistina: TSV-liitäntöjen ansiosta CUBE yhdistää suuren kaistanleveyden ja pienen tehonkulutuksen, mikä tekee siitä ihanteellisen AI-SoC:eihin mobiili- ja edge-laitteissa.

- Yhteistyö OSAT-kumppaneiden kanssa: Winbond työskentelee kokoonpano- ja testitalojen kanssa parantaakseen muistipakkausten integraatiota seuraavan sukupolven AI-laitteisiin ja vähentääkseen latenssia.

- Tulevaisuuteen suuntautuvat DRAM-innovaatiot: Winbondin tiekartta sisältää tekoälylle viritettyjä DRAM-ratkaisuja, erikoistuneita välimuistirakenteita ja optimoituja LPDDR-arkkitehtuureja HPC-, robotiikka- ja reaaliaikaisen AI-prosessoinnin tarpeisiin.

Tekoälytyökuormien kasvu, suorituskyvyn skaalautumisen rajoitteet ja energiatehokkaiden muistiratkaisujen tarve muokkaavat muistimarkkinoita perusteellisesti. Generatiivinen tekoäly lisää jatkuvasti pieniviiveisten ja suurikaistaisten muistien kysyntää, mikä vauhdittaa innovaatioita DRAMissa ja räätälöidyissä muistiratkaisuissa.

Winbondin edelläkävijyys CUBE-muistissa sekä DDR5- ja LPDDR-kehityksessä tekee siitä keskeisen mahdollistajan seuraavan sukupolven tekoälylaskennassa. Kun tekoälymallit kasvavat yhä monimutkaisemmiksi, optimoitujen ja energiatehokkaiden muistiratkaisujen merkitys korostuu entisestään. Winbondin jatkuva innovointi pitää sen eturintamassa kohti skaalautuvia, suorituskykyisiä ja kestäviä AI-muistiarkkitehtuureja.