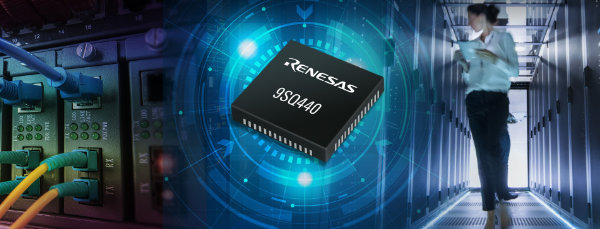

Göteborgilainen ZeroPoint Technologies AB on julkistanut uuden laitteistokiihdytetyn muistioptimointituotteen, AI-MX:n, joka parantaa merkittävästi suurten kielimallien (LLM) suorituskykyä ja tehokkuutta. Teknologia mahdollistaa mallien lähes välittömän pakkauksen ja purkamisen, mikä voi tuoda miljardiluokan säästöjä datakeskuksille.

Generatiivisen tekoälyn räjähdysmäinen kasvu on nostanut datakeskusten muistitarpeet ennennäkemättömälle tasolle. ZeroPoint Technologiesin uusi AI-MX-tuote vastaa tähän haasteeseen pakkaamalla LLM-mallit tehokkaammin, mikä kasvattaa muistin hyötysuhdetta ja kaistanleveyttä jopa 1,5-kertaiseksi.

- LLM-mallit kuormittavat jo nyt datakeskusten resursseja äärimmilleen. AI-MX on ensimmäinen laatuaan ja voi säästää yrityksiltä miljardeja dollareita tekoälyn käyttöön liittyvissä infrastruktuurikustannuksissa, kertoo ZeroPointin toimitusjohtaja Klas Moreau.

AI-MX mahdollistaa sen, että esimerkiksi 150 gigatavun kokoinen malli voidaan ajaa vain 100 gigatavun HBM-muistissa ilman suorituskykyhäviöitä. Lisäksi teknologia parantaa muistikaistan leveyttä ja energiatehokkuutta, mikä auttaa hyperskaala- ja yritysdatasenttereitä käsittelemään enemmän tekoälykyselyitä samalla raudalla.

Perinteiset ohjelmistopohjaiset pakkaukset ovat liian hitaita reaalimaailman AI-sovelluksiin, mutta ZeroPointin laitteistokiihdytetty ratkaisu toimii yli 1000 kertaa nopeammin kuin perinteiset algoritmit. AI-MX tukee laajasti erilaisia muistityyppejä, kuten HBM, LPDDR, GDDR ja DDR, mikä tekee siitä yhteensopivan useimpiin AI-laskentaympäristöihin.

ZeroPointin teknologiaa pidetään merkittävänä harppauksena AI:n muistioptimoinnissa, ja se voi leikata hyperskaalattujen palvelinkeskusten ylläpitokustannuksia jopa 25 prosentilla. Ensimmäiset AI-MX-tuotteet toimitetaan asiakkaille vuoden 2025 jälkimmäisellä puoliskolla, ja yritys aikoo kehittää tekniikkaa edelleen kohti vielä suurempia tehokkuusparannuksia.

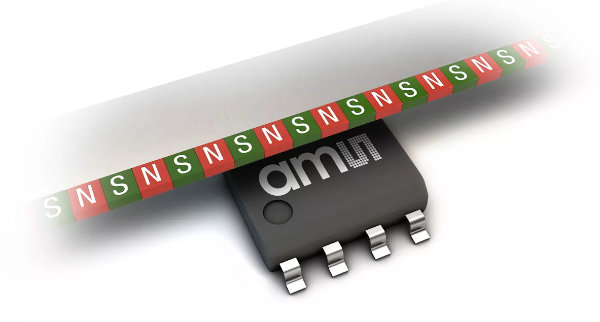

Virtaamamittaus on monissa laitteissa kriittinen mutta usein ongelmallinen toiminto. Perinteiset mekaaniset anturit kuluvat ja jäävät sokeiksi pienille virtausnopeuksille. Ultraäänitekniikkaan perustuvat valmiit moduulit tarjoavat nyt tarkan, huoltovapaan ja helposti integroitavan vaihtoehdon niin kuluttaja- kuin teollisuussovelluksiin.

Virtaamamittaus on monissa laitteissa kriittinen mutta usein ongelmallinen toiminto. Perinteiset mekaaniset anturit kuluvat ja jäävät sokeiksi pienille virtausnopeuksille. Ultraäänitekniikkaan perustuvat valmiit moduulit tarjoavat nyt tarkan, huoltovapaan ja helposti integroitavan vaihtoehdon niin kuluttaja- kuin teollisuussovelluksiin.